Analizando el archivo robots.txt

Qué es el robots.txt

El archivo de texto robots.txt según wikipedia es un archivo que suelen tener todas las webs y en concreto todos los CMS donde está escrito en el lo que se quiere ocultar a los buscadores. Por ejemplo si tenemos hecha una web con el gestor de contenidos Wordpress en ese archivo robots.txt vendrá la orden para que Google no rastree la url donde está ubicado el wp-admin ya que a través de ahí accederemos al login de la administración del sitio.

Este archivo es una pieza clave para alguien que quiera colarse en tu página web de la forma más sencilla, a través del menú de administración, por eso es muy importante tenerlo bien configurado y en la medida de lo posible bien protegido.

Por el consiguiente vamos a usar una herramienta desarrollada en python para analizar el archivo robots.txt, esta herramienta la podemos clonar directamente desde el repositorio del desarrollador.

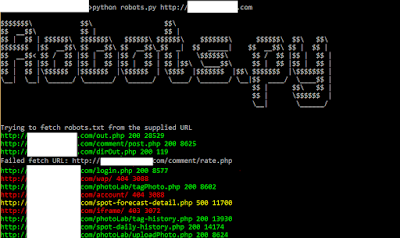

Una vez tenemos la herramienta clonada la lanzamos entrando en el terminal, en la carpeta de la herramienta y poniendo lo siguiente:

python robots.py sitioweb.comSi todo ha ido correctamente nos debería dar un pantallazo tal y como así, con toda la información del robots.txt del sitio web.

Recordar que estamos abiertos a todo tipo de correcciones.

Para más info puedes consultarnos en nuestro email info@rekat.es o a través de nuestra página web https://rekat.es

Saludos! 👾

Comentarios

Publicar un comentario